YAPAY SİNİR AĞLARI

Bilgisayar teknolojilerinin gelişmesiyle birlikte insanoğlu neredeyse tüm işlemlerini bu yenilikçi teknolojiler üzerinde yapmakta ve yeni yöntemlerin bulunmasına olanak sağlamaktadır. İşte bu yüzdendir ki, 1980’li yıllarda ortaya atılan makinanın insan gibi düşünebilmesi fikri ortaya atılmış, 1990’lı yıllara gelindiğinde ise Yapay Sinir Ağları teknolojisi iyiden iyiye hızlanmış ve büyük bir gelişme görülmüştür.

Yapay Sinir Ağları, Yapay Zekâ kavramı altında oluşan bir alt başlık olup, bu konuya ilgi duyan araştırmacıların odak noktası haline gelmiştir.

Bu bölümde Yapay Sinir Ağları teorik açıdan anlatılmış olup, alt başlıklar halinde uygulamaları yer almıştır.

Yapay Sinir Ağları Tanımı ve Tarihçesi

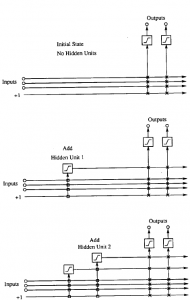

Yapay sinir ağları örneklerle ilgili bilgiler toplamakta, genellemeler yapmakta ve daha sonra hiç görmediği örnekler ile karşılaştırılınca öğrendiği bilgileri kullanarak o örnekler hakkında karar verebilmektedir. Yapay sinir ağları bu öğrenebilme ve genelleme özellikleri nedeniyle günümüzde birçok bilim alanında geniş uygulama olanağı bulmakta ve karmaşık problemleri başarı ile çözebilme yeteneğini ortaya koymaktadır (Ergezer vd, 2003).

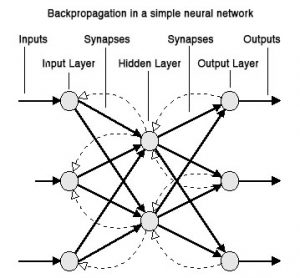

Diğer bir tanıma göre yapay sinir ağları; insan beyninden esinlenerek geliştirilmiş, ağırlıklı bağlantılar aracılığıyla birbirine bağlanan ve her biri kendi belleğine sahip işlem elemanlarından oluşan paralel ve dağıtılmış bilgi isleme yapıları; bir başka deyişle, biyolojik sinir ağlarını taklit eden bilgisayar programlarıdır (Elmas, 2003).

Yapay sinir ağlarının dayandığı ilk hesaplama modelinin temelleri 1940’ların başında araştırmalarına başlayan W.S. McCulloch ve W.A. Pitts’in, 1943 yılında yayınladıkları bir makaleyle atılmış olmuştur. Daha sonra 1954 yılında B.G. Farley ve W.A. Clark tarafından bir ağ içerisinde uyarılara tepki veren, uyarılara adapte olabilen model oluşturulmuştur. 1960 yılı ise ilk neural bilgisayarın ortaya çıkış yılıdır. 1963 yılında basit modellerin ilk eksiklikleri fark edilmiş, ancak başarılı sonuçların alınması 1970 ve 1980’lerde termodinamikteki teorik yapıların doğrusal olmayan ağların geliştirilmesinde kullanılmasına kadar gecikmiştir. 1985 yapay sinir ağlarının oldukça tanındığı, yoğun araştırmaların başladığı yıl olmuştur (Mehra Pankaj Wah W Benjamin, 1992).

Yapay sinir ağlarının kullanım alanları: Kontrol ve sistem tanımlama, görüntü ve ses tanıma, tahmin ve kestirim, arıza analizi, tıp, haberleşme, trafik, üretim yönetimi olarak sayılabilir(Pirim, 2006). Çizelge 1’de geleneksel algoritmalar ile YSA’ların karşılaştırma tablosu görülmektedir.

| Geleneksel Algoritmalar |

Yapay Sinir Ağları |

| Çıkışlar, koyulan kurallara girişlerin uygulanması ile elde edilir. |

Öğrenme esnasında giriş çıkış bilgileri verilerek, kurallar koyulur. |

| Bilgiler ve algoritmalar kesindir. |

Deneyimden yararlanır. |

| Hesaplama; merkezi, eş zamanlı ve ardışıktır. |

Hesaplama; toplu, eş zamansız ve öğrenmeden sonra paraleldir. |

| Bellek paketlenmiş ve hazır bilgi depolanmıştır. |

Bellek ayrılmış ve ağa yayılmıştır. |

| Hata toleransı yoktur. |

Hata toleransı vardır. |

| Nispeten hızlıdır. |

Yavaş ve donanıma bağımlıdır. |

Çizelge 1 Geleneksel Algoritmalar ile YSA’ların Karşılaştırılması (Pirim, 2006)

Devamını Oku