Tekrarlı Basamak Korelasyon Sinir Ağları

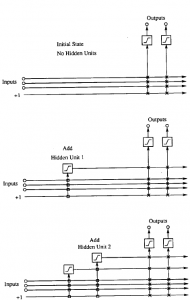

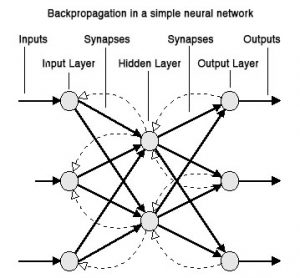

Eğer örneklerin sırası belirli bir modelse, rekurrent (tekrarlı) sinir ağları (RSA) ileri beslemelerden daha iyi probleme uyumlu olabilir. RSA güncel olan veya önceki katmanlara doğru geri beslemeli bağlantılara sahiptir, böylece veri ağ içerisinde yayılabilir. Bu verileri kullanarak giriş ve çıkış modellerinin tanıma yetisi kısa bir zaman diliminde simule edilebilir. Ne yazık ki genel bir RSA için etkili bir öğrenme algoritması bulunmamaktadır. Fahlman (1991) tarafından yayımlanan makalesinde belirtildiği üzere, sadece bazı rekurrent mimari öğrenme metodları rekurrent basamak korelasyon mimarisinin de içinde yer aldığı etkili öğrenme metodlarına sahiptir (Fahlman, 1991). Çünkü Basamak korelasyon sinir ağı (BKSA) eğitimi dondurulan bir nöronun ağırlıkları değişmez, yeni aday nöronlar aktif nöronlara doğru bağlantılara geri besleme yapamazlar. Böylece tek seçenek, Rekurrent Basamak Korelasyon (RBK) tarafından uygulanan mimari, her bir nöron kendi-rekurrent (tekrarlı) bağlantısına (kendi çıkışı bir giriş değeri gibi davranır) sahip olduğu zaman ki bu aday öğrenme süresince eğitilebilir ve sonrasında dondurulur. Sonrasında nöronların hesaplama modeli şöyle değişir: